ACL 2025:大模型公平性与多模态融合获突破

在今年的秋季,维也纳成了自然语言处理领域的“香饽饽”,ACL 2025会议带来了巨大的涟漪,尤其是大模型在公平性和多模态融合上的突破,引发了来自世界各地的关注。这个场合,简直像是科技热点的一个大展台,让人忍不住想探究,这些千层面般复杂的大模型到底在做些什么魔法,怎么又跳出了传统的单一文本框架,朝着更加广阔的认知疆域迈步了。

别再糊弄了:从MMLU到MMLU-CF的公平革命

过去几年,我们都知道评测大语言模型的“独角戏”MMLU(大规模多任务语言理解)多么风光,但它也有个不怎么光彩的小秘密——数据污染。想象你去参加考试,考官提前把答案偷偷发给了同学,公平吗?当模型训练用的开源数据和评测题目有重叠时,模型“作弊”的可能性极大,评测结果的公信力一下子打了折扣。

微软亚洲研究院针对此痛点推出的MMLU-CF版本就像给这个考试系统进行了深度“清道夫”式的扫除,设立了严格的去污染机制,还很细心地将测试集闭源保密,为的就是重塑公平正义的天平。多学科学训考察,才真正让模型面对“干净”的挑战,看看它们到底有多硬核。对我个人来说,这不仅是科学技术的进步,更像一次社会公正的小革命——毕竟,让机器带偏了思想,那后果真的不堪设想。

公平性不是“讲故事”的能力,支持多文化才是王道

我们说公平,不只是让模型“别作弊”,更在于它是否尊重、理解各种语言和文化背后的独特性。ACL 2025上微软的ShifCon框架令人眼前一亮,它不是一味堆积数据,而是选择一种比较智慧的、多语言迁移策略,尤其注重资源稀缺语言的表现。哎,说实在的,语言可不是只有英语和汉语那两根枝条,成千上万的方言、小语种,都是人类文明瑰宝,这些模型对它们“视而不见”简直不能忍。

还有个很有趣的SocialCC项目,仿佛在给大模型上了个跨文化“社交课”,指出模型在处理多元文化时的偏差。你看,要机器学会带点“人情味”,考虑多样的社会文化背景,才不至于给人制造一盆冰冷的算法汤。或许这就是机器与人类沟通时的最大障碍之一,它既不能把世界当成一潭死水,也不能把每个文化当成独立审判庭,不断平衡中寻找共生。

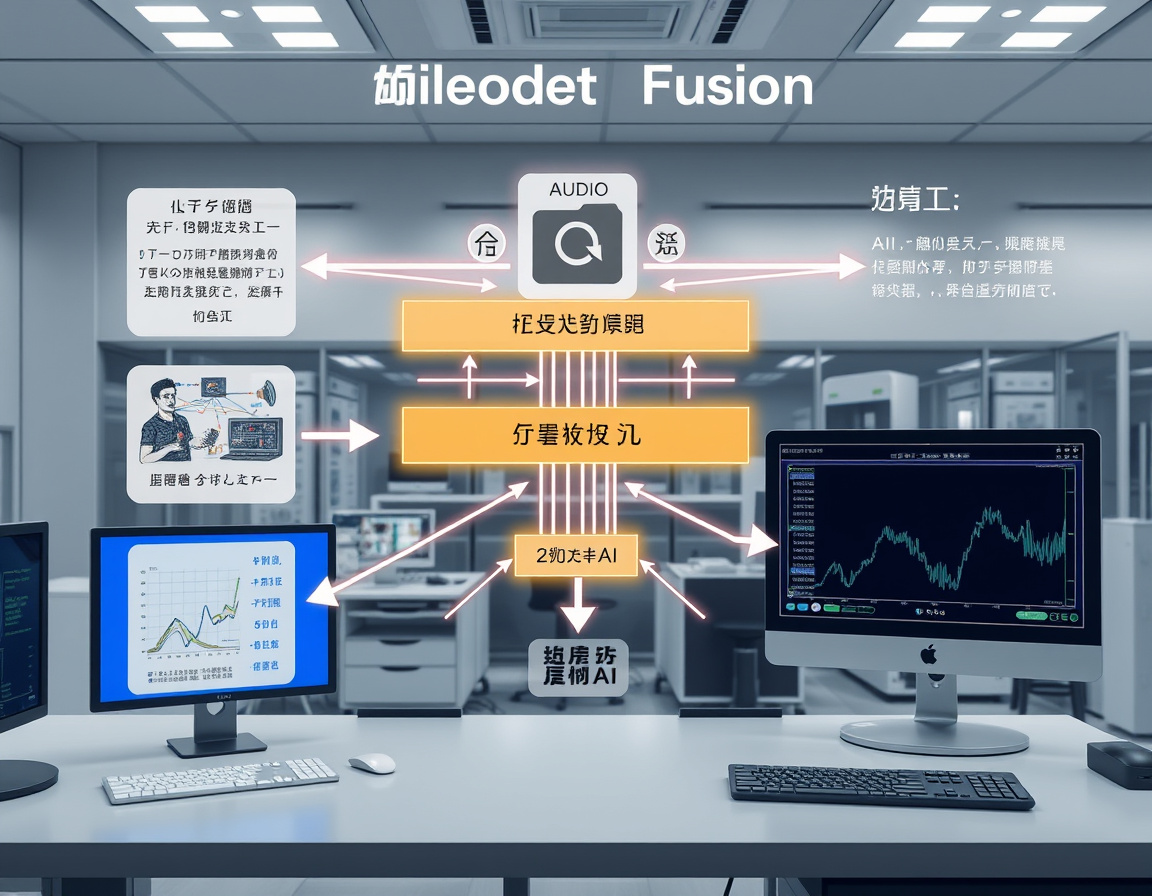

多模态革命:文字、视觉、声音齐发力

说到大模型的“升级”,多模态能力绝对是这届ACL的C位。远远不是简单把图片和文字“拼拼凑凑”,而是融合到骨子里,形成一种异构专家系统——这听起来有点“炫技”,举个例子吧,百度文心4.5 Turbo通过引入三维旋转位置编码,让模型的视觉识别和理解效率提升了近两倍,这等于给模型装上了“立体眼镜”,不仅识得眼前物,还能看清细节和关系。

不仅如此,字节跳动的深度思考模型则更像个“高级顾问”,能结合图片分析地貌,还能看懂复杂的项目管理流程图。想想你把复杂的图表、照片投入它的“大脑”,它却能娴熟地将信息拆解、理解,这可不是普通的“文本聊天机器人”,而是真正的跨媒体思考者。

多模态深度融合的浪潮已不可阻挡。百度李彦宏曾多次提到,单靠文本的时代终将过去,未来是多模态的天下。确实,机器人能理解声音、视频乃至三维运动,才不至于变成只会背课文的“死读书人”,反而像一个多才多艺的全能艺术家,跳动在现实世界的每个细节中。

伦理的边界,技术的重压

不过,技术的进步绝不应该是“任性”的代名词。ACL 2025会议还重点拎出了一个话题:价值准则的对齐和伦理风险。说白了,模型不只是为了“聪明”而聪明,而更得考虑它带来的社会影响,谁为它的偏见买单?

从心理学角度出发,看待模型可能产生的非预期危害,这就像你养了一只不听话的宠物,得花心思教它分辨善恶。研究者提出了多层次的防护,涵盖设计、训练和使用环节,淋漓尽致地体现出公平与责任并重的追求。我个人觉得,这份谨慎感是科技发展的大脑袋不可或缺的安全阀。否则,仅有锦上添花的功能,没有道德底线的制衡,技术再酷也可能是颗“定时炸弹”。

总有些东西,很想要,也不得不放手

回看这场ACL2025的大戏,科技热点之下的“盛世繁华”背后挑战其实不少。大模型的极致,既是算力、算法的“马拉松”,更是心理和社会的“拔河战”,公平性、公正性和安全之间的拉锯战无处不在。就像你想让一个跷跷板保持平衡,不加点人情味和社会责任那真跳不过去。

未来,随着多模态技术步入成熟,模型不仅仅是信息的搬运工,更多成了人类认知的合作伙伴。它懂得你的语言,也理解你的文化,甚至读懂环境。或许有一天,这些大模型能不只是智能助手,而是真的成为我们复杂世界的“引路人”。但愿如此。

人类和机器的这场戏才刚刚开篇,而ACL 2025无疑拉开了序幕——一场技术与伦理、效率与公平、传统与创新不停碰撞的长跑。至于结果,呵,还是等时间去揭晓吧。

评论功能已关闭