Qwen3-235B-A22B突破26万token窗口极限,MoE架构兼顾性能效率

科技热点的大模型领域又掀起一阵波澜,2025年7月,Qwen3-235B-A22B-Instruct-2507横空出世,刷新了上下文窗口的极限,直接把Token数跑到了令人咋舌的26万——对,你没听错,是26.2万个Token!这可不是简单吹牛,而是实打实推动了大语言模型可以处理的最长上下文长度的边界,给长文本、全代码库理解乃至跨章节复杂推理带来了革命性的可能。

上下文窗口,越长越香?

说起来,上下文窗口的扩容,总给人一种“越长越能聊”的感觉,可其中真有那么简单吗?不然早就不是几十万Token的钱袋子了。大模型在处理超长文本时,原有的自注意力机制会面临计算复杂度指数级暴涨的问题,这不仅烧钱,还容易让模型跑偏或“忘词”,结果就是上下文一长,结果就不够扎实。

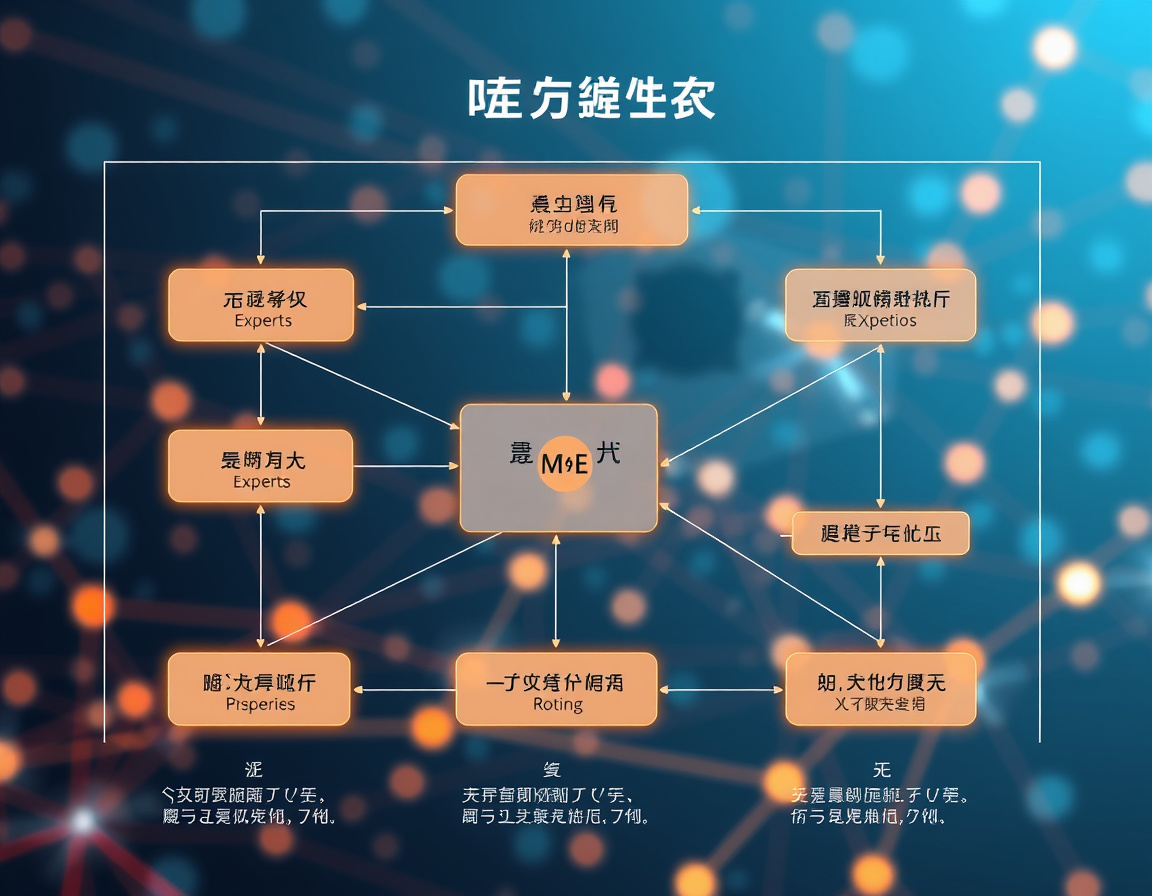

那么Qwen3-235B-A22B-Instruct-2507是怎么实现这飞跃的?别以为是啥黑科技的魔法,它主要靠的是MoE架构——混合专家模型(Mixture of Experts)。简单理解一下:模型内部有许多“专家小分队”,但实际推理时,只激活其中一部分,也就是“定向点拨”,而不是全员出动。你想啊,原本用一整个军团打仗,改成只派出最合适的兵种,效率自然翻倍。更棒的是,这招还能大幅度降低算力消耗,还避免了由于参数冗余带来的效率浪费。这一点,可以说直接点燃了性能与效率的双重引擎。

再说性能,别光顾着跑长远距离了

性能和效率往往是对立体,模型要么大,要么快,谁也不服谁。但Qwen3-235B-A22B-Instruct-2507打破了这条死板法则。它采用的专家子网络激活机制,让模型整体参数达到2350亿规模,但推理时激活的只有220亿,这意味着在性能输出几乎不打折的同时,计算负担大砍一刀。想想看,对科研和工业界应用来说,效率提升那么多,简直是降本增效的福音。

探讨这点,不禁让我想起以前深夜调试模型时的崩溃感:资源不够、响应慢、还得担心跑题。现在呢?有了这样的大模型,像是配备了超强引擎的“智能车”,不仅一路开得稳、开得远,还省油!而且在语义理解的深度和广度上,Qwen3-235B-A22B依然保持了不掉链子。毕竟,性能不够,窗口管的再长也白搭。

多语言、多模态,才是增添未来底气

聊性能不提多语言,那就不完整了。2025年之后,多语言模型已非新鲜事,但深度结合MoE架构让Qwen3-235B-A22B-Instruct-2507的多语言处理更为得心应手。无论是英文、中文,还是其他主流语言,它都游刃有余,甚至能轻松应对一些低资源语言。

此外,业界不少大厂将目光投向多模态融合,语言模型能与图像、视频等数据一起联动才是大势所趋。虽然Qwen3-235B-A22B当前主攻文本,但强大的架构设计为未来多模态升级腾出了空间。毕竟,在多任务和多模态的道路上,层层推进、步步为营,才能保证技术的长青和生态的健壮。

碰撞与酝酿:前路还很长

说到这里,来点八卦:科技圈这几年像没节操的连续剧,OpenAI、Google Gemini、DeepSeek、Anthropic……一个赛一个地推新模型。Qwen3-235B-A22B-Instruct-2507能突围,不光因为它“做大做强做优”,更靠对上下文窗口瓶颈的精准“击穿”,还有MoE的脚踏实地,这两点可是核心密码。

然而,26万Token虽是光环,应用场景才是硬指标。长文本分析、法务文书解析、医学报告梳理、完整项目代码库修改,场景的多样化会倒逼模型不断锤炼自己的耐力与精准度。不仅要能“听得懂”,还能“答得妙”,还得在关键时刻不“翻车”。这是一个细节和场景驱动的发展时代。

总结来说,Qwen3-235B-A22B-Instruct-2507的出现,不仅是技术里程碑,更像是敲开了大模型新房间的大门。上下文打开、效率攀升、多语言通吃,这些标签贴得刚刚好。当然,它也提醒着我们,AI不该仅仅满足于参数堆积,更要在功耗和实际意义上找平衡,这样才能把未来握得更实。大模型圈,从来不是一个单纯的“谁更大”的比拼,而锁定的是“谁更懂需求,谁更可持续”。

毕竟,25年的AI世界,变得快得像脱缰的野马,但稳下来,才是王道。你说呢?

评论功能已关闭