谷歌TimesFM-2.5发布:长上下文时间序列预测模型准确率领先

谷歌TimesFM-2.5发布:长上下文时间序列预测模型准确率领先

这次谷歌又搞出了一点意思——TimesFM-2.5,一款定位精准的时间序列预测大模型,刚一亮相就刷屏了科技热点。说实话,我一开始还以为巨头们都只管语言模型,没想到这次在时间序列数据上真下了苦功。时间序列预测这种事儿,听着简单,玩儿起来就像解谜,尤其是在数据段越来越长的情况下,谁能把握住那长长条条里的细节,谁就能赢。

时间序列预测的花样与痛点

先来理理时间序列预测是啥东西。它不只是看眼前几秒几分钟的数据,而是分析漫长时间的轨迹,像气象预报里那种连续多年的温度变化,或者金融市场中分分钟不同的股价波动。但问题在于,传统模型往往只能“记”有限的时间跨度。一旦跨度拉长,模型头脑就像老年痴呆患者,记不住之前的细节了,预测准确性也大打折扣。实话说,数据多了反倒成了负担,就像背着一大堆行李旅游,走几百米就喘不过气。

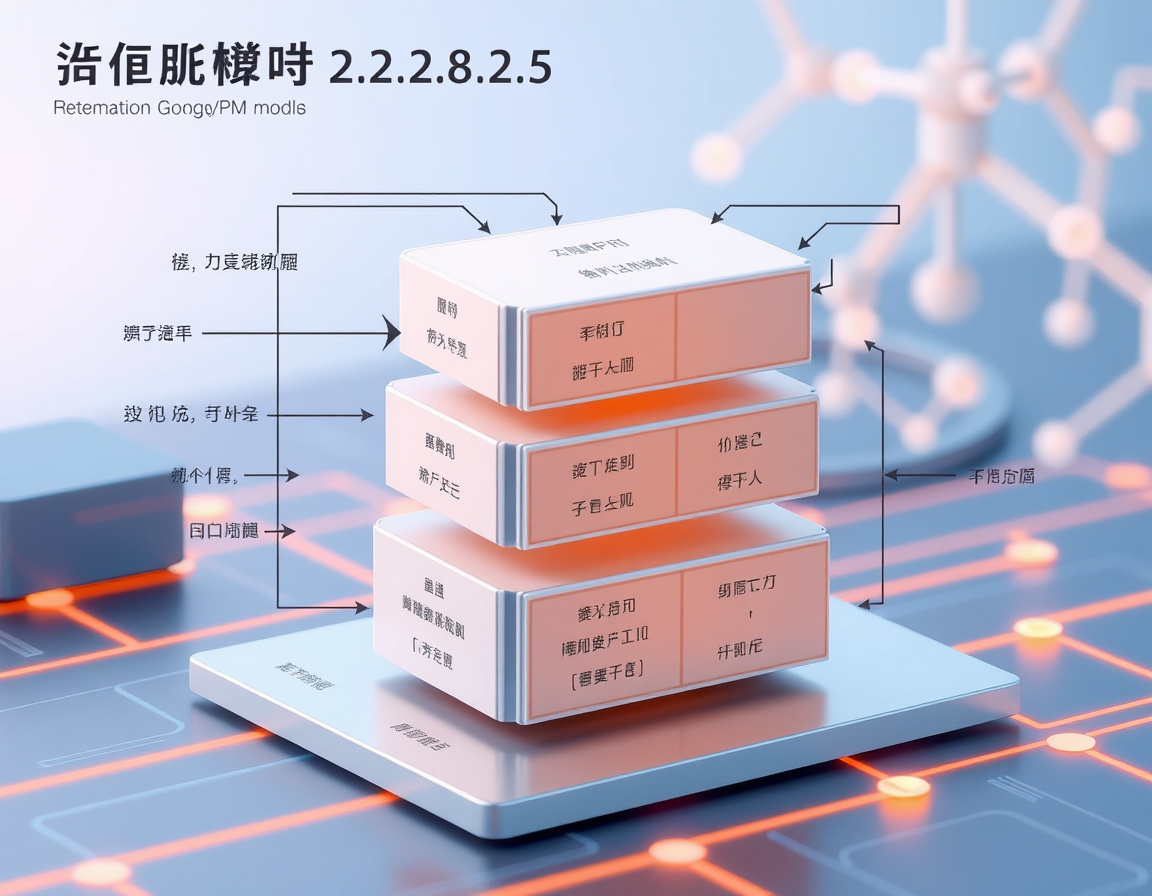

而谷歌这次的TimesFM-2.5,硬是突破了这条“记忆天花板”。它支持多达16,384个时间步的上下文数据输入,也就是模型的大脑可以同时“思考”1万多条连续数据点的故事。参数规模只有2亿(对比先前那个500M参数的版本),看着小巧,可背后的魔法却很厉害。

小个头,大能耐

为什么我会觉得TimesFM-2.5有点像“弹簧侠”这种小个子超级英雄?因为虽然只有2亿参数,但表现却领先于那些个头巨大的模型。相比传统500M参数的TimesFM版本,TimesFM-2.5竟然把参数精简了60%以上,却提升了上下文能力。难得这不是“缩水”,而是技术精炼的结果。这种“轻量化但不轻视性能”的设计理念,恰恰是当下大模型追求的方向。

讲实在的,这个单一解码器架构也很有看头。它意味着模型结构更简单,运行更高效。要知道,复杂结构往往带来算力负担和延迟,做实际落地就很难推开。TimesFM-2.5解决了这个矛盾,既保持预测力道,也节约了资源,这对工业界来说无疑是福音。

关于本地概率预测:不只是定结果,更给未来留余地

读到这里,有人可能会问,“预测不就是得给个准确数吗?何必搞什么概率预测?”嘿,这就是新时代的智能体现了。传统预测那是一根筋,给你个点,结果要么准,要么不准。但现实数据本身带着不确定性,像天气总会变脸,市场总在涨跌波动中没个准头。

TimesFM-2.5支持“本地概率预测”,指的就是模型对未来的种种可能性有了量化的描述,告诉你每种结果出现的概率有多大。这样一来,管理者可以有底气地做多场景规划,而不是盲从单一预测结果。风险评估一下子提高了一个等级,也让整个时间序列预测更智慧、更“人性化”。

大模型江湖中的独特分支

把视野拉宽,科技热点的大模型现在火得一塌糊涂,OpenAI、Meta等都疯狂造“巨兽”,百亿起步,参数多到吓人眼球。可是这些大模型专注语言或者图像,TimesFM-2.5却在时间序列这一细分领域做到了极致。上下文长度高达1.6万,这早就甩开了很多标准大语言模型的几千token限制了。

这如同拳击擂台上的重量级和次重量级的较量,虽然参数不如某些超大型模型庞大,但细分领域的专业度,让TimesFM-2.5在精准时间序列预测上无可替代。这也反映了大模型发展的一条脉络——不是越大越好,而是要在特定领域里“专精特新”。

助推未来产业数字化转型

最后,得说说这东西对现实的影响。你试想,零售业卖东西,能准确预测需求,能避免积压和缺货;气象部门能更准确地预测极端天气,提前做好防范;金融市场能更明晰风险波动,投资决策更稳健……这些背后,都离不开时间序列预测的飞跃。

谷歌这次的TimesFM-2.5,无疑将在多个行业的数字化转型大潮中,扮演关键推进器的角色。它不仅仅是个科研玩具,更多的是注入了实用价值的大模型应用实践。或许不久的将来,我们的生活里会越来越多看到这种长上下文时间序列模型的影子。

就像当年Transformer改变了自然语言处理的游戏规则,TimesFM-2.5可能正悄悄揭开时间序列分析的新篇章。在科技热点不断翻涌的今天,谁能掌握时间脉络,谁就掌握了未来。

是不是又很心动?让我等着看,谷歌这款小而精的时间序列大模型,究竟能在市场和科研里搅起多大的浪花。

评论功能已关闭